Albert Einstein kojarzy się głównie z teorią względności: szczególną i potem ogólną. Jego zainteresowania obejmowały jednak całość gmachu fizyki, jak nikt bowiem troszczył się o logiczną spójność i prostotę całości, wiele jego prac brało początek nie tyle z konkretnych problemów, ile raczej z potrzeby uzgodnienia różnych punktów widzenia. Tematyka teorii względności nie pochłaniała też większości jego czasu i uwagi. W pierwszym, najbardziej twórczym, ćwierćwieczu swej działalności był Einstein jednym z pionierów i mistrzów fizyki statystycznej. Dziedzina ta wyrosła z kinetycznej teorii gazów w sposób prawie niezauważalny w pierwszych latach XX wieku. Metody statystyczne zastosowane do gazów i rozwinięte przez Ludwiga Boltzmanna uogólnił Einstein w latach 1902-1904 na dowolne układy składające się z wielu cząstek. Nie wiedział wówczas, że dobiegający kresu życia Josiah Willard Gibbs sformułował tę samą teorię w książce Elementary Principles in Statistical Mechanics wydanej w Stanach Zjednoczonych w roku 1902. Gibbs, który spędził niemal całe życie w New Haven w Connecticut jako profesor uniwersytetu Yale, był pierwszym i aż do lat trzydziestych jedynym wybitnym teoretykiem amerykańskim. Jego prace znane były w Europie, lecz Einstein zapoznał się z książką Gibbsa dopiero po ukazaniu się jej niemieckiego przekładu i stwierdził, że gdyby znał ją wcześniej, to nie napisałby swoich trzech wczesnych prac dotyczących podstaw fizyki statystycznej. Bez wątpienia przyczyniły się one wszakże do jego naukowego rozwoju, technikami statystycznymi posługiwał się bowiem później z wielkim wyczuciem i pewnością.

Lata 1896-1905 są w rozwoju naukowym Einsteina okresem bodaj najciekawszym, wtedy właśnie ukształtował się uczony, który w roku 1905 ogłosił cztery przełomowe prace stawiające w nowym świetle kilka naraz dziedzin fizyki. Pierwsza z nich dotyczyła cząstkowej natury światła i była najbardziej może rewolucyjna. Czwarta dotyczyła teorii względności, czyli jak to wtedy mówiono, elektrodynamiki ciał w ruchu. Do swego przyjaciela Conrada Habichta Einstein pisał wtedy:

Praca druga zawiera określenie rzeczywistych rozmiarów atomów na podstawie dyfuzji oraz lepkości w rozcieńczonych roztworach substancji obojętnych. Trzecia natomiast dowodzi, iż z założeń molekularnej [kinetycznej] teorii ciepła wynika, że cząstki o średnicy rzędu 1/1000 mm, tworzące zawiesinę w cieczy, muszą wykonywać dostrzegalne, chaotyczne ruchy, spowodowane ruchami cieplnymi [cząsteczek cieczy]; w rzeczy samej, fizjologowie zaobserwowali niewyjaśnione [słowo skreślone przez autora listu – J.K.] ruchy małych nieożywionych cząstek w zawiesinach, które nazwano molekularnymi ruchami Browna.

Robert Brown, wybitny botanik, zaobserwował to zjawisko w roku 1827, badając pod mikroskopem pyłki klarkii nadobnej i wydzielane przez nie drobne cząstki (amyloplasty i sferosomy). Otóż cząstki te wykonywały nieustający zygzakowaty ruch. Brown sumiennie i metodycznie podszedł do swego odkrycia, stwierdzając, że podobne ruchy obserwuje się także w przypadku drobnych cząstek nieorganicznych, nie mają więc one nic wspólnego z życiem. Do końca wieku XIX zjawiskiem ruchów Browna zajmowali się od czasu do czasu fizycy, nie zaowocowało to jednak żadnymi charakterystykami ilościowymi. Mimo że rozwinęła się wówczas kinetyczna teoria gazów i powtarzano od czasu do czasu wyjaśnienie zjawiska za pomocą zderzeń z cząsteczkami cieczy, nikomu nie udało się wyjść poza ogólniki. Charakterystyczne są tu uwagi Henri Poincarégo w książce Nauka i hipoteza. Matematyk pisze tu o zjawiskach nieodwracalnych, podlegają one prawu wzrostu entropii, trudno więc uzgodnić je z zasadami mechaniki, które są odwracalne:

Przez długi czas termodynamika ograniczała się do badań nad rozszerzaniem się ciał i zmian w ich stanie. Od pewnego czasu stała się ona zuchwalszą i znacznie rozszerzyła swój zakres. Zawdzięczamy jej teorię stosu, teorię zjawisk termoelektrycznych; nie ma w całej fizyce kąta, który by nie był objęty jej badaniami; zaatakowała ona nawet chemię. Wszędzie panują te same prawa; wszędzie pod rozmaitością pozorów odnajdujemy zasadę Carnota [tj. drugą zasadę termodynamiki], wszędzie również owo tak niesłychanie abstrakcyjne pojęcie entropii, równie powszechne jak pojęcie energii i jak ono posiadające cechy czegoś realnego. Ciepło promieniste zdawało się jej nie podlegać; przekonano się niedawno, że i ono znajduje się pod panowaniem tych samych praw. (…)

Usiłowano również znaleźć wytłumaczenie mechaniczne tych zjawisk [nieodwracalnych] we właściwym znaczeniu. Nie nadawały się one jednak do tego. Aby wytłumaczenie to znaleźć, należało np. przypuścić, że nieodwracalność jest tylko pozorna, że zjawiska elementarne są odwracalne i ulegają znanym prawom dynamiki. Lecz elementy są nadzwyczaj liczne i mieszają się ze sobą coraz bardziej, tak iż dla tępych naszych oczu wszystko zdaje się zdążać do jednostajności, czyli wszystko zdaje się postępować w jednym kierunku, bez nadziei powrotu. Pozorna nieodwracalność jest tedy po prostu przejawem prawa wielkich liczb. Jedynie istota o zmysłach nieskończenie subtelnych, w rodzaju urojonego demona Maxwella, potrafiłaby rozwikłać tę poplątaną sieć i zawrócić świat wstecz.

Koncepcja ta, związana z teorią kinetyczną gazów, powstała kosztem wielkich wysiłków i ostatecznie okazała się mało płodną, może się stać nią jednak. Nie tutaj miejsce rozpatrywać, czy nie prowadzi ona do sprzeczności, i czy odpowiada ściśle rzeczywistej naturze rzeczy.

Wspomnijmy przecież o oryginalnych pomysłach fizyka Gouy’ego, dotyczących ruchu brownowskiego. Według tego badacza osobliwy ten rodzaj ruchu uchyla się od zasady Carnota. Cząstki, które wprawia on we wstrząśnienie, mają być mniejsze niż oka tej tak gęsto zasnutej sieci; mogą one przeto oka te rozwikłać i w ten sposób kazać światu postępować wstecz. [Nauka i hypoteza, przeł. M.H. Horwitza pod red. L. Silbersteina, Warszawa-Lwów 1908, pisownia uwspółcześniona]

Zaprezentowaliśmy ten cytat nie tylko dla zobrazowania poglądów panujących w pierwszych latach XX wieku, ale i dlatego, że książkę Poincarégo czytał Einstein z przyjaciółmi, Conradem Habichtem (adresatem listu powyżej) i Mauricem Solovine. Utworzyli oni nieformalną grupę samokształceniową, którą nazywali żartobliwie Akademią Olympia – wszyscy trzej byli raczej bez grosza i postrzegali siebie jako outsiderów wobec rozmaitych szacownych ciał oficjalnych. Niewykluczone, że Einstein wiedział na temat ruchów Browna tyle albo niewiele więcej niż można znaleźć u Poincarégo.

Akademia Olympia w pełnym składzie, pierwszy z lewej Conrad Habicht.

W odróżnieniu od franuskiego luminarza nauki młody Einstein nie miał wątpliwości, że metody statystyczne Boltzmanna, czyli mechanika statystyczna, mogą objaśnić także zjawiska nieodwracalne (np. zamianę pracy na ciepło pod wpływem tarcia albo oporu ośrodka). Na poziomie molekularnym nie widać zresztą, w którą stronę płynie czas. Nie widać tego także w ruchach Browna. Drobna, lecz ogromna w skali molekularnej, cząstka pod mikroskopem porusza się pod wpływem chaotycznych zderzeń z cząsteczkami cieczy bądź gazu. Zderzenia te przekazują obserwowanej cząstce pewien pęd, ruch wypadkowy jest tu skutkiem nierównomierności tych zderzeń: czasem przekazują one pęd w jednym kierunku, czasem w innym. W rezultacie cząstka porusza się osobliwym zygzakowatym ruchem. Uczeni badający to zjawisko przed Einsteinem starali się np. zmierzyć prędkość ruchów Browna, otrzymywali jednak wyniki niespójne i nie dające się ująć w żadne prawidłowości. W ruchach Browna decydujące znaczenie mają odchylenia od średnich – fluktuacje statystyczne, a nie same średnie. Badanie fluktuacji metodami fizyki statystycznej stało się ulubionym podejściem Einsteina w wielu zagadnieniach. Nastawienie to odróżniało go nie tylko od konserwatystów w rodzaju Poincarégo, ale także od pionierów: Boltzmanna i Gibbsa, którzy koncentrowali się raczej na tym, jak metodami statystycznymi powtórzyć wyniki termodynamiczne. Młody uczony, którego na razie nikt nie traktował na tyle serio, by dać mu posadę na uczelni, szedł więc tutaj zupełnie samodzielną drogą. Można powiedzieć, że był prekursorem stosowania prawdopodobieństw w fizyce. Metody probabilistyczne odróżniają zdecydowanie fizykę XX wieku od szukającej wszędzie absolutnej pewności fizyki dziewiętnastowiecznej. Choć Einstein nigdy nie pogodził się z brakiem determinizmu na poziomie zjawisk podstawowych (słynne „Bóg nie gra w kości!”), to sam przyczynił się w znacznym stopniu do zmiany podejścia uczonych i wprowadzenia metod statystycznych.

W pracy z 1905 roku Einstein nie był pewien, czy to, co opisuje to owe słynne ruchy Browna. Pisze:

Niewykluczone, że omawiane tu ruchy są identyczne z tak zwanymi molekularnymi ruchami Browna, ale dostępne mi dane na ich temat są tak nieprecyzyjne, iż nie mogłem w tej sprawie sformułować opinii. (przeł. P. Amsterdamski)

Warto zauważyć, że sto lat temu dostęp do informacji naukowej był zgoła niełatwy, zwłaszcza dla kogoś, kto pracował przez cały dzień w biurze i w godzinach pracy nie mógł chodzić do biblioteki naukowej. Oczywiście Einsteinowi chodzi tu o coś więcej niż samą kwestię ruchów Browna:

Jeżeli ruchy, które tu omówimy, rzeczywiście można zaobserwować i jeżeli spełnione są prawa, którym powinny podlegać, to nie sposób dalej utrzymywać, że termodynamika klasyczna zachowuje ważność w sytuacji, gdy poszczególne obiekty dają się odróżnić nawet za pomocą mikroskopu, i ścisłe wyznaczenie rzeczywistych rozmiarów atomowych staje się możliwe. Z drugiej strony, jeżeli przewidywania dotyczące tych ruchów okażą się błędne, fakt ten stanowiłby bardzo poważny argument przeci molekularno-kinetycznej teorii ciepła. (przekł. jw.)

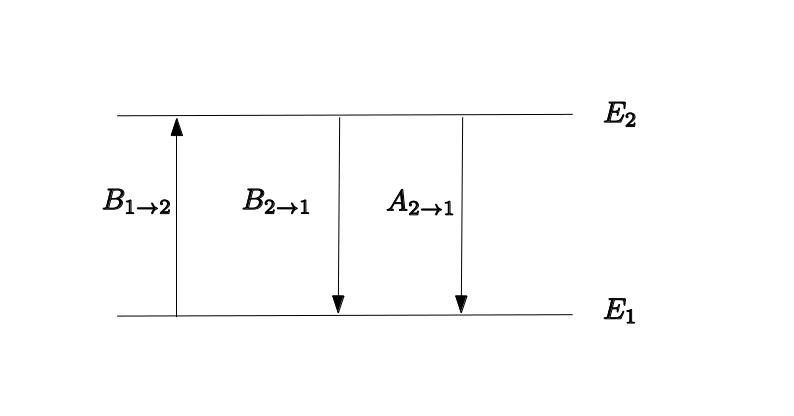

Einstein stosuje do opisu ruchu cząstki brownowskiej rachunek prawdopodobieństwa. W jednym wymiarze rozkład prawdopodobieństwa zależny od położenia i czasu

opisany jest funkcją

. Zakładamy, że położenia cząstki w chwili późniejszej

są statystycznie niezależne od położeń w chwili

. Mamy wtedy równanie:

gdzie jest pewnym symetrycznym rozkładem prawdopodobieństwa. Czytelnik zechce zauważyć podobieństwo do podejścia Louisa Bacheliera, o którym Einstein nic nie wiedział wtedy ani zresztą także i później, ich trajektorie naukowe nigdy się nie przecięły. Einstein rozwija w szereg Taylora funkcję po lewej stronie względem czasu, a po prawej względem położenia, ograniczając się do najniższych pochodnych dających nietrywialny wynik:

Po uproszczeniu otrzymujemy równanie dyfuzji:

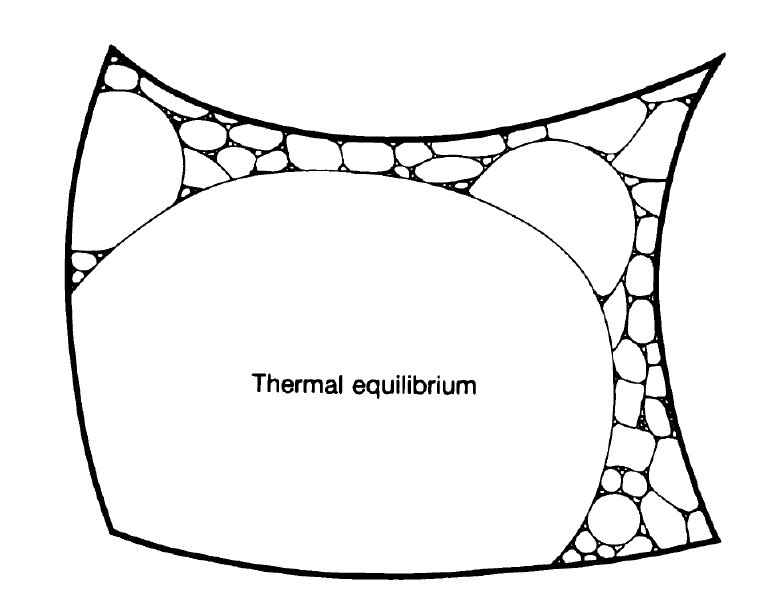

Jest to równanie opisujące rozkład prawdopodobieństwa położeń pojedynczej cząstki (jeśli cząstek jest niewiele, to ich ruchy powinny być niezależne). Rozwiązanie znane było powszechnie i można je zapisać następująco:

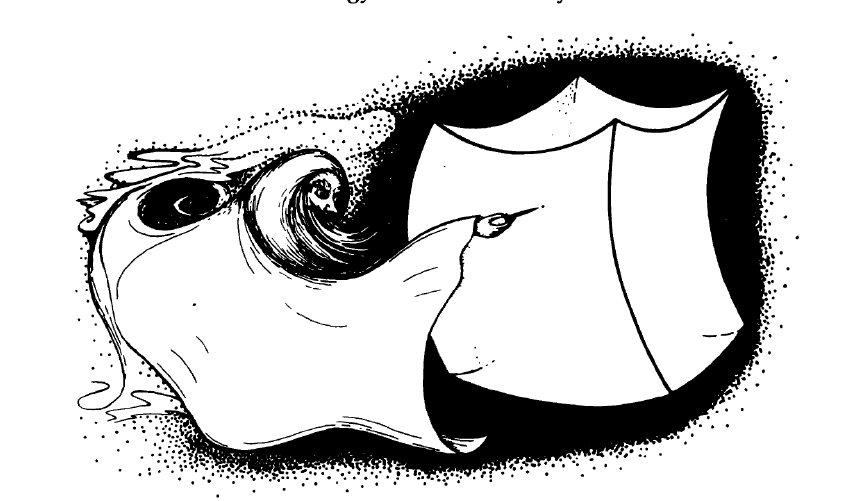

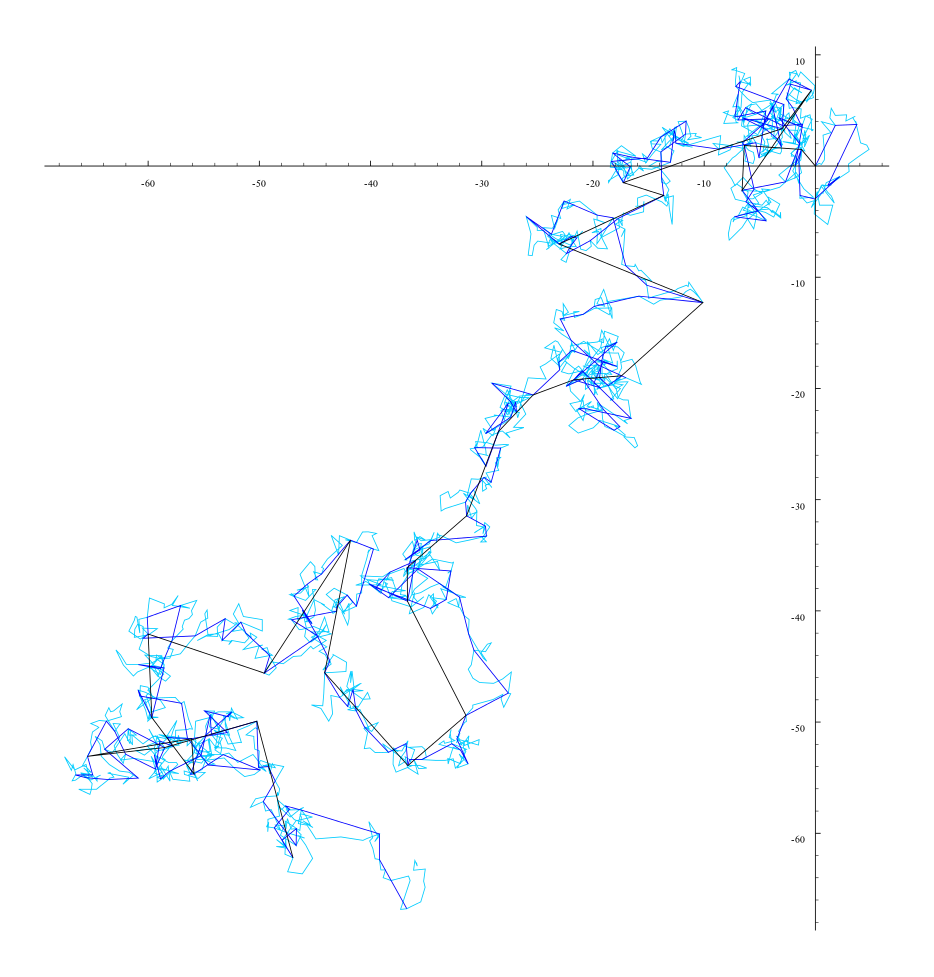

Mamy więc mały cud: bardzo nieregularne ruchy odpowiadają gładkiemu rozkładowi gaussowskiemu, który rozpływa się z czasem. Wygląda to jakoś tak.

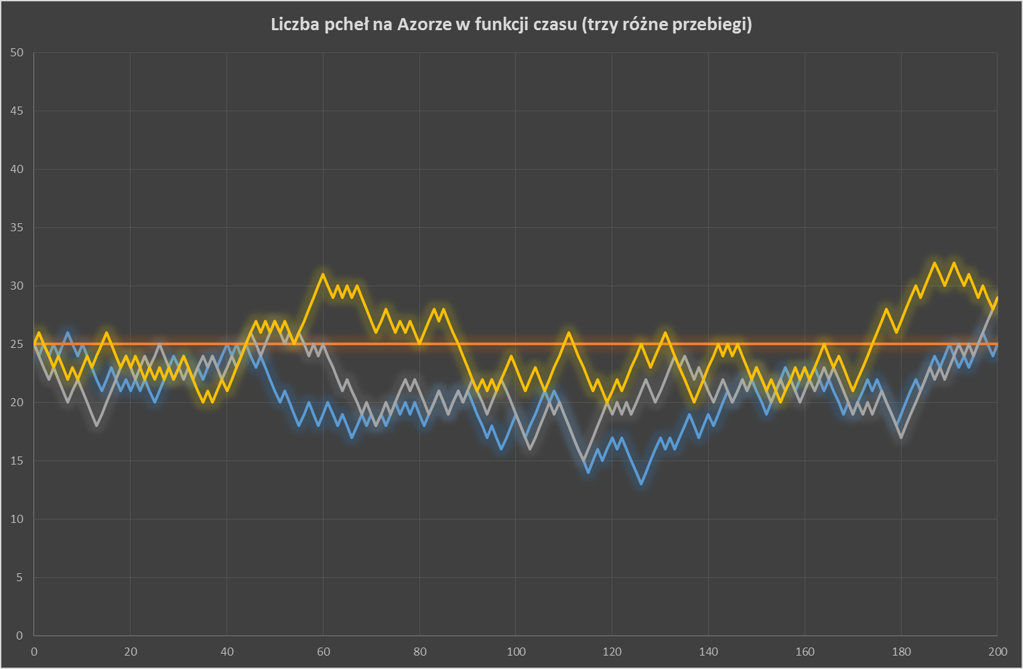

Biorąc pewną próbkę błądzących cząstek, otrzymamy histogram częstości, który dla wielu prób zbieżny będzie do rozkładu Gaussa. Jest to zagadnienie błądzenia przypadkowego, o którym pisaliśmy niedawno. Z punktu widzenia Einsteina najważniejsza była wartość średnia , czyli dyspersja rozkładu (kwadrat odchylenia standardowego):

Einstein powiązał współczynnik z lepkością ośrodka

i promieniem cząstek brownowskich

oraz temperaturą

, otrzymując

Zależność tę przetestował później Jean Perrin, potwierdzając wyniki Einsteina i Mariana Smoluchowskiego, który trochę później ogłosił równoważną teorię ruchów Browna. Dzięki temu potwierdzono istnienie atomów, a także słuszność fizyki statystycznej jako metody badania obiektów makro− i mezoskopowych.

Temperatura, przy której magnetyzacja spada do zera, to tzw. temperatura Curie (chodzi o doktorat Pierre’a Curie jeszcze przed ślubem z naszą rodaczką Marią Skłodowską). Oczywiście magnetyzacje dodatnie i ujemne są tak samo możliwe. Układ ochładzany poniżej

Temperatura, przy której magnetyzacja spada do zera, to tzw. temperatura Curie (chodzi o doktorat Pierre’a Curie jeszcze przed ślubem z naszą rodaczką Marią Skłodowską). Oczywiście magnetyzacje dodatnie i ujemne są tak samo możliwe. Układ ochładzany poniżej