Wyobrażam sobie, że Ziemia się kręci, lecz nie dla racji, jakie przedstawiał Kopernik, ale z tych to względów: ogień piekielny, jak uczy Pismo Święte, jest zamknięty we wnętrzu Ziemi, a potępieni, pragnąc uciec przed żarem płomienia, wspinają się aż pod strop, obracając przy tym Ziemię; tak samo pies zamknięty w kole obraca je, drepcząc.

Cyrano de Bergerac (przeł. J. Rogoziński)

Campanella w swojej Apologii przedstawia nieco naciąganą listę zwolenników idei ruchu Ziemi. Występuje na niej żyjący w XV wieku kardynał Mikołaj z Kuzy, którego taka możliwość bynajmniej nie gorszyła, choć trudno go uznać za prekursora Kopernika w sensie ściśle naukowym. Pojawia się też „Nolańczyk i inni, których imion nie możemy wymienić z powodu ich herezji. Nie zostali jednak potępieni z tej przyczyny”.i Nolańczyk to oczywiście Giordano Bruno; przypominanie, że był zwolennikiem ruchu Ziemi nie było dyplomatyczne. Można jednak sądzić, że nie tylko Campanella, ale i Bellarmin, a także inni hierarchowie, słysząc o Koperniku, myśleli o Brunie, i nie miało większego znaczenia, jaki rodzaj kopernikanizmu wyznawał Bruno ani to, że nie był on w sensie technicznym astronomem. Większość nazwisk na liście Campanelli stanowią uczeni protestanccy. Niektórzy, np. Erasmus Reinhold, stosowali tylko kopernikańską technikę obliczeniową, inni, tacy jak Michael Mästlin i jego uczeń Kepler, byli autentycznymi zwolennikami nowej astronomii.

Mogłoby się wydawać, że szczególnie gorące dyskusje wywoła kopernikanizm wśród protestantów, przyzwyczajonych do samodzielnej lektury Pisma, podczas gdy wśród katolików znajomość Biblii ograniczona była do kleru i bardzo wąskiej garstki ludzi wykształconych. Tak się jednak nie stało, potępienia kopernikanizmu przez teologów protestanckich były najwyżej incydentami bez większych konsekwencji. Luter nie interesował się tym problemem wcale, Jan Kalwin uznał, że skoro Pismo nie zgadza się z Ptolemeuszem, to tym samym nie przeczy Kopernikowi, i powoływanie się w dyskusjach astronomicznych na święty tekst jest nieuprawnione. Pismo Święte było przystosowane do czytelników i nie miało na celu nauczania astronomii czy innych nauk szczegółowych.ii Doktryna Kalwina wywarła wielki wpływ na świat protestancki i ułatwiła także przyjęcie kopernikanizmu.

Najwybitniejszym astronomem epoki był bez wątpienia Johannes Kepler, odkrywca praw rządzących ruchem planet. Kepler był żarliwym luteraninem, więc problem sprzeczności kopernikanizmu z Pismem Świętym stanął przed nim w sposób naturalny. Swe stanowisko przedstawił w długiej przedmowie do Astronomia nova, znanej zapewne Galileuszowi. W słowach Psalmu 19: „raduje się jak olbrzym ruszający do biegu”, Kepler widział jedynie sformułowanie poetyckie, dostosowane do sposobu, w jaki zjawiska przedstawiają się naszym oczom. Widzimy, że Słońce się porusza, nie znaczy to jednak, że naprawdę porusza się Słońce, a nie Ziemia. Kepler omawia także cud Jozuego. Słowa wodza Izraelitów: „Stań, słońce, nad Gibeonem! I ty, księżycu, nad doliną Ajjalonu!” (Joz 10,12), wskazują wyraźnie, względem jakiego układu odniesienia zatrzymać się miały oba ciała niebieskie. Chodziło o to, aby się nie poruszały, oświetlając scenę bitwy: dla Jozuego cały dzień stały one pośrodku nieba, a dla ludzi znajdujących się po drugiej stronie globu tak samo długo znajdowały się pod ziemią. Zatem nawet zwolennik tradycyjnej kosmologii musi przyznać, że sformułowanie Jozuego wcale nie jest do końca oczywiste, ukryte są w nim pewne założenia: to samo usytuowanie Słońca względem Ziemi oznacza dzień dla jednych, noc dla drugich. „Jozue miał tylko to jedno życzenie, aby góry nie zasłaniały mu słońca, i wyraził je słowami zgodnymi z tym, co widać; bo czymś nienaturalnym byłoby w owej chwili rozmyślać o astronomii i złudzeniach wzroku. Gdyż jeśliby ktoś zwrócił mu uwagę, że Słońce nie porusza się naprawdę względem doliny Ajjalonu, lecz jedynie tak się wydaje, to czyż nie zakrzyknąłby Jozue, że pragnie jedynie, aby dzień się wydłużył, wszystko jedno w jaki sposób? Tak samo by postąpił, gdyby ktoś z nim wtedy wszczął spór na temat spoczynku Słońca i ruchu Ziemi. Ze słów Jozuego Bóg z łatwością zrozumiał, jakie jest jego życzenie, i spełnił je, wstrzymując ruch Ziemi, tak aby Jozuemu zdawało się, że stanęło Słońce”.

Kepler, choć sam nie miał żadnych wątpliwości co do kopernikanizmu, uważał go za doktrynę trudną, przeznaczoną dla uczonych: „Przeto zaklinam mego czytelnika, aby nie zapominając o bożych dobrodziejstwach zesłanych ludziom (…), po powrocie ze świątyni wstąpił do szkoły astronomii. (…) Kto jednak jest zbyt niepojętny, aby móc zrozumieć naukę astronomii, albo zbyt trwożliwy, by bez zgorszenia dla swojej pobożności uwierzyć Kopernikowi, temu radzę, aby opuścił szkołę astronomii, zostawił w spokoju nauki filozoficzne i poświęcił się własnym sprawom”.iii Dla umysłów pośrednich proponował Kepler system Tychona, zaczynający właśnie zdobywać sobie popularność wśród jezuitów, gdyż nie zrywał tak gwałtownie z tradycją i bliższy był arystotelesowsko-tomistycznej filozofii, która była oficjalną doktryną Towarzystwa Jezusowego.

W roku 1617 Kepler otrzymał za pośrednictwem jednego ze swych korespondentów rozprawkę Ingolego De situ et quiete Terrae contra Copernici systema disputatio. Zareagował na nią w maju następnego roku tekstem Responsio ad Ingoli Disputationem („Odpowiedź na dysputę Ingolego”), który z kolei doczekał się w październiku odpowiedzi Ingolego. Cała ta polemika nie została opublikowana, krążyła jednak w odpisach wśród zainteresowanych. Z dużym opóźnieniem, bo dopiero w roku 1624, włączył się do niej Galileusz, pisząc Lettera a Francesco Ingoli („List do Francesca Ingolego”).

Ingoli wkrótce po napisaniu swej pierwszej rozprawki i ogłoszeniu dekretu Kongregacji Indeksu w sprawie Kopernika został mianowany konsultorem tej kongregacji. Mogło to wynikać stąd, że jego patronowi, kardynałowi Caetaniemu, powierzono zadanie przygotowania poprawek do dzieła Kopernika, niewątpliwie jednak nominacja taka była ważnym dowodem zaufania wobec Ingolego. On też miał ostatecznie zająć się poprawkami do Kopernika. Był więc w tych latach jedną z bardziej widocznych postaci po stronie kościelnej, osobą, która prywatnie wygłaszała poglądy zgodne z decyzjami Kościoła hierarchicznego. We wszystkich tych wypadkach astronomowie jezuiccy milczeli, zachowując posłuszeństwo, zaiste perinde ac cadaver – „na podobieństwo trupa” – i nawet pytani o zdanie, nie próbowali wpłynąć na stanowisko Kościoła.

Gdyby nie szczególne usytuowanie jej autora, rozprawka Ingolego nie byłaby może ciekawa, zawiera bowiem jedynie to, czego można by się spodziewać po inteligentnym dyletancie: znane z literatury naukowej argumenty antykopernikańskie oraz pewną liczbę nieporozumień. Dziełko rozważa trzy rodzaje argumentów: matematyczne, fizyczne i teologiczne. Już pierwszy argument obniża oczekiwania czytelnika co do reszty: „Gdyby Słońce było w środku świata, to miałoby większą paralaksę niż Księżyc, ale ponieważ następnik jest fałszywy, więc fałszywy musi być i poprzednik”. Ingoli nie rozumiał, że wielkość paralaksy wiąże się jedynie z odległością ciała od Ziemi i błąd ten, jak się zdaje, bez skutku starali się mu wyperswadować dwaj najwybitniejsi żyjący uczeni. Bardziej interesujące były argumenty teologiczne. Z Księgi Rodzaju dowiadujemy się, że Stwórca stworzył na firmamencie ciała niebieskie. A „firmament” i jego hebrajski odpowiednik znaczą tyle co rozciągłość czy przestwór, a więc obwód, a nie środek. Zatem największe ciało niebieskie – Słońce – nie może być w środku świata. Innym argumentem niech będzie fakt, że piekło – miejsce przebywania demonów i potępionych – musi być jak najdalej od nieba, a więc w środku Ziemi. Stąd mamy zstępowanie do piekła i wstępowanie do nieba. Tyle na temat położeń Słońca i Ziemi. Jeśli chodzi o ruch, wystarczy przytoczyć cud Jozuego (a jakże! – widzimy, dlaczego możliwe wyjaśnienie tego właśnie cudu podał Galileusz), a ponadto w hymnie kościelnym Telluris ingens Conditor mamy słowa: „Ziemię stworzyłeś nieruchomą”.iv Warto zauważyć, że dwa z czterech argumentów odnosiły się nie do Pisma, lecz do wiary wywodzącej się z tradycji: usytuowanie piekła oraz hymn kościelny. Jakkolwiek osobliwie by wyglądały takie argumenty z folkloru, Ingoli i jego mocodawcy nie żartowali. Zapewne chodziło o podkreślenie różnicy między Kościołem rzymskim a zrywającymi z tradycją „heretykami” (którzy odwdzięczali się „papistom” zarzutami o kultywowanie zabobonów). Z przytoczenia cudu Jozuego można chyba wywnioskować, że o. Caccini nie strzelał na ślepo podczas swego kazania i miał w Rzymie poparcie. Ingoli udzielił też z góry odpowiedzi na argument, iż cud Jozuego mógłby być opisany w Piśmie językiem dostosowanym do ludzkiego pojmowania: wszyscy Ojcowie Kościoła objaśniają ten ustęp w taki sposób, że Ziemia jest nieruchoma, a Słońce się porusza. Sobór trydencki postanowił, iż nie wolno odchodzić od interpretacji Ojców; wprawdzie dotyczyło to kwestii wiary i moralności, ale nie da się zaprzeczyć, że zmiana interpretacji nie spodobałaby się Ojcom Kościoła. W ostatecznym rozrachunku o tym, co jest zgodne z tradycją, decydował Rzym, a co znajduje posłuch w Rzymie, Ingoli wiedział bardzo dobrze. Powołanie się na Ojców Kościoła wskazywało na katolicką proweniencję tej wykładni – dla protestantów pogląd Ojców Kościoła nie był wiążący.

Zauważmy też, że nie ma tu miejsca na subtelności: nie tylko interpretacja Pisma, ale cała wiedza ludzka nie może wykraczać poza to, co dostępne było intelektualnie Ojcom Kościoła w pierwszych wiekach nowej ery. Biblijny obraz świata miał być alfą i omegą wszelkiego poznania. Trudno o bardziej antynaukowe stanowisko.

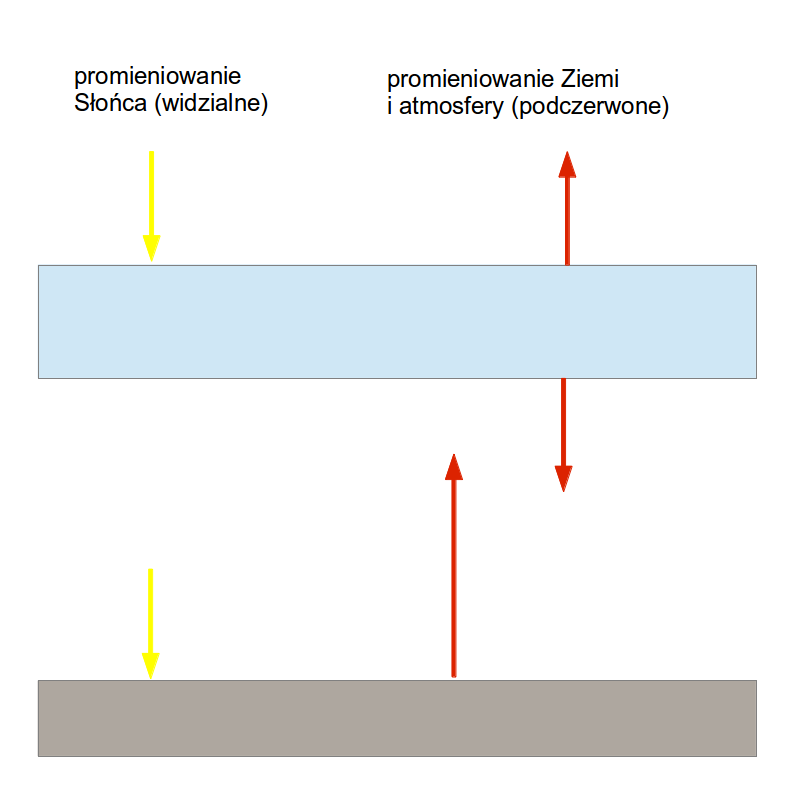

Johannes Kepler nie słyszał o dekrecie Kongregacji Indeksu, dochodziły do niego tylko niejednoznaczne informacje. Nie wiedział też, kim jest Ingoli i jaką rolę odgrywa w Rzymie. Jako zdeklarowany zwolennik Kopernika gotów był jednak dyskutować na ten temat z każdym. Był astronomem katolickiego cesarza, ale przez całe ćwierćwiecze mógł swobodnie przyznawać się do kopernikańskich poglądów i nie spotkały go z tego tytułu żadne szykany, jeśli nie liczyć niechęci teologów luterańskich w Tybindze. W roku 1618 Kepler wydał trzy pierwsze księgi dzieła Epitome astronomiae copernicanae („Skrót astronomii kopernikańskiej”), które było streszczeniem jego dojrzałych poglądów na astronomię. W tych początkowych księgach omawiał podstawy astronomii: sferę niebieską, pory roku, wschody i zachody ciał niebieskich. Czynił to jednak od początku z punktu widzenia kopernikańskiego. Przedstawiał bliżej ruch dobowy Ziemi i jego fizyczne konsekwencje. Znalazł się też tam rysunek przedstawiający kopernikańskie wyjaśnienie pór roku na Ziemi. Najważniejsze osiągnięcia naukowe Keplera zawarte były w dalszych księgach Epitome, przygotowywanych wówczas do druku, ale również ta część wstępna miała zdecydowanie kopernikański charakter.

Polemizując z Ingolim, Kepler odpowiadał na zarzuty, które nieraz już słyszał, choćby od samego Tychona Brahego, swego poprzednika na stanowisku cesarskiego astronoma. Dlatego też w wielu sprawach odsyłał Ingolego do tekstu Epitome. Na płaszczyźnie czysto naukowej nie było mowy o ich równorzędnej dyskusji, która zresztą i tak nie mogła sprawy rozstrzygnąć. Kepler jako astronom starał się zrozumieć, jak funkcjonuje kosmos, wychodząc z obserwacji i doskonale rozumiejąc, czego trzeba, aby te obserwacje opisać. Ingoli, z wykształcenia doktor obojga praw, pozostawał na płaszczyźnie filozoficznej czy raczej popularnonaukowej i mógł swobodnie krytykować różne założenia i koncepcje, nic go to bowiem nie kosztowało: wszystko pozostawało abstrakcyjnym ćwiczeniem retorycznym w stylu dysput na średniowiecznych uniwersytetach. Przyznanie komuś racji zależało wyłącznie od uznania jego argumentów, co w ostatecznym rozrachunku sprowadzało się do wiary w takie lub inne założenia metafizyczne.

Kopernikanizm w naturalny sposób prowadził do ujednolicenia opisu różnych części wszechświata, dzięki czemu można było np. ziemską mechanikę zastosować do zjawisk kosmicznych. W Epitome Kepler następująco pisze o wirowaniu Ziemi wokół osi:

„Jeśli chłopcy mogą wprawić w obrót bączka w którąkolwiek stronę, tym bardziej równomiernym i ustalonym ruchem, im mocniejszy ruch mu nadadzą, tak że bączek, raz puszczony w ruch, mocą swego impetu wykonuje wiele obrotów, aż powstrzymany przez nierówności podłogi i opór powietrza, a także pokonany własnym ciężarem, stopniowo zwalniając, upada, to czemu Bóg nie mógłby Ziemi na początku nadać takiego ruchu, jakby z zewnątrz, że nawet dzisiaj, po wielu kolejnych obrotach, wiruje z takim samym wigorem, choć było ich już dwieście tysięcy, gdyż wirowaniu temu nie przeszkadzają wystające nierówności ani gęstość eteru, ani też jej waga, czyli wewnętrzna ciężkość; ile ma bowiem bezwładności ze swej materii, tym większą skłonność do przyjęcia impetu i kontynuowania obrotów”.v Kepler, podobnie zresztą jak Galileusz, zwrócił uwagę, że Ziemia zachowuje stałą orientację osi obrotu w przestrzeni – i że odpowiada to sytuacji wirującego mechanicznego bąka. W odpowiedzi Ingoli pisze, że „nie można wiedzieć a priori, czy Bóg nadał Ziemi ruch, inaczej niż z Pisma Świętego albo dzięki objawieniu, ale żaden z tych sposobów nie prowadzi do wniosku, że Bóg nadał ruch Ziemi, gdyż z Pisma Świętego dowiadujemy się o nieruchomości Ziemi”.vi W ten sposób po raz kolejny Pismo Święte staje się granicą możliwej do pomyślenia nauki.

Kepler nie musiał liczyć się z władzami rzymskimi, mógł więc, w przeciwieństwie do Galileusza, przedstawić swoją odpowiedź na teologiczną argumentację Ingolego. Na argument o największym oddaleniu zbawionych od potępionych zauważa z rozbawieniem, że „gdybyśmy szukali dla zbawionych i potępionych miejsc obdarzonych takimi własnościami geometrycznymi, to łatwo byśmy przyznali miejsce środkowe zbawionym, gdyż środek jest pod strażą Jowisza, natomiast potępieni zostaliby wyrzuceni ze świata w zewnętrzne ciemności, gdzie zgrzytają zębami”. Całkiem już na serio stwierdzał, że teologowie nie powinni mieszać się do astronomii, podobnie jak astronomowie nie powinni wkraczać na obszary wiary i obyczaju, zarezerwowane dla teologii. Co do dosłownego rozumienia Pisma stwierdzał: „Ilekroć w jego wyjaśnianiu odchodzimy od sensu naocznego, natychmiast pojawiają się wielkie różnice między interpretatorami (…). Gdy tylko można, należy zachować sens dosłowny. Piękna zasada. Powiedz zatem – pytam – jaki sędzia ustala, czy można go zachować? Czyż nie wspólne doświadczenie ludzkie? Należy więc wysłuchać także i mniej potocznego doświadczenia astronomów i tam, gdzie oni powiedzą, że nie jest możliwe, aby dane stwierdzenia były zgodne z sensem naocznym i zarazem prawdziwe oraz zgodne co do joty z astronomią, tam interpretator Pisma powinien przestać się troszczyć o sens astronomiczny”.vii

Niemiecki astronom był nie tylko gorącym zwolennikiem kopernikanizmu, ale także miłośnikiem spokojnej, rzeczowej argumentacji. Uważał, że dyskusje naukowe należy pozostawić uczonym. Ingerencji duchownych i teologów obawiał się tym bardziej, że widział na każdym kroku, jak ostre formy przybiera konflikt wyznaniowy: właśnie w roku 1618 rozpoczęła się wojna religijna, znana w historii jako wojna trzydziestoletnia. Zdając sobie sprawę, że nauka Kopernika nie jest łatwa do przyjęcia dla ogółu, nie upierał się, by nauczać jej powszechnie. Tam jednak, gdzie prowadzi się dyskusję naukową, nie wolno w niej używać argumentów religijnych, jeśli sam temat nie łączy się z kwestiami wiary i moralności.

Nie należy lekceważyć trudności, jakich doświadczali zwolennicy tradycyjnej kosmologii w zetknięciu z kopernikanizmem. Jednak średniowieczna filozofia nominalistów czy św. Tomasza także nigdy nie zawędrowały pod strzechy. Od pasterzy Kościoła, powszechnego choćby tylko z nazwy, można było wymagać, by nie angażowali się z taką energią w sprawy budowy astronomicznego kosmosu. Argumenty Ingolego dotyczące piekła wskazują wszakże na pewną trudność: tradycyjna kosmologia Arystotelesa, schrystianizowana w średniowieczu, przydzielała konkretne miejsce niebu i piekłu. Najbardziej sugestywny opis takiego wszechświata pozostawił Dante Alighieri w Boskiej Komedii. Średniowieczny kosmos był nie tylko geocentryczny, ale także diablocentryczny – w środku Ziemi znajdował się bowiem sam Lucyfer. Topografią dantejskiego piekła zajmował się młody Galileusz w rozprawie odczytanej przed Akademią florencką. To, co dla niego było może tylko szczególnym ćwiczeniem poetycko-matematycznym, dla wielu innych stanowiło element wiary religijnej.

Z filozoficznego punktu widzenia nie ma potrzeby przypisywania jakiejś lokalizacji przestrzennej duszom zmarłych, piekłu i niebu, jednak wyobraźnia ludzka szuka przestrzennych ram pojęciowych. Cała kultura kontrreformacji, barok z jego przerysowanymi gestami i przeładowanymi dekoracjami, przepych ceremonii w Rzymie, naśladowanych we wszystkich diecezjach katolickiej Europy, odwoływały się do wyobraźni wizualnej. Epoka uwielbiała teatralne przedstawienia, które aktualizowały w czasie i przestrzeni rozmaite wydarzenia z historii świętej. Sztuka katolicka obrała zupełnie inną orientację niż sztuka w protestanckiej części Europy, gdzie zwyciężyli ikonoklaści. Cudowne sceny z historii świętej malowane i rzeźbione przez artystów katolickich usiłowały zamienić dynamikę cudu na migawkowe ujęcie: wstępowanie do nieba wyglądało niemal jak telewizyjny reportaż na żywo. Cała ta kultura wizualizacji świętości zagrożona była kopernikanizmem. I to zapewne rodziło głęboką i być może nie zawsze jasno uświadamianą niechęć rzymskich prałatów do naruszania kosmicznego status quo. Ów problem, by tak rzec, religijnej wyobraźni przestrzennej na dłuższą metę okazał się poważny. Wielu chrześcijan tu właśnie upatrywało źródło uwiądu religijnego, jaki dotknął cywilizację europejską kilku ostatnich stuleci.viii

Odpowiadając Keplerowi, Ingoli informuje nas przy okazji o tym, jaki klimat intelektualny panował wówczas w Rzymie. Prace nad poprawkami do Kopernika były już na ukończeniu i Ingoli uznał, że powinien wystąpić jako obrońca właściwej wersji chrześcijaństwa oraz jedynie słusznej filozofii. Nie tylko on jeden tak sądził, do napisania tej rozprawki namawiał go Ludovico Ridolfi, główny szambelan (maestro di camera) papieża Pawła V i jednocześnie radca cesarski. „Po pierwsze, mówiłeś – pisze Ingoli – nie przystoi w żaden sposób, aby prawda o miejscu Ziemi w środku świata i jej nieruchomości pozostawała bez obrony, zwłaszcza dziś, gdy jest ona – i to stanowi drugi punkt – ponad wszelką wątpliwość katolicka. Dodawałeś ponadto, że wiem, jak miłe będzie to moje studium kardynałom Świętej Kongregacji Indeksu, gdyż lepiej niż ktokolwiek wiem, co sądzą oni o poglądach Keplera na ten temat. Gdy zauważyłem, że księgi Kopernika, o których zdawałem tam relację, ledwie uniknęły wiecznego potępienia, odrzekłeś, iż gdyby nie uznano ich użyteczności dla ogółu w kwestii skorygowania i poprawienia ruchów niebieskich i gdyby nie możliwość ich ocalenia na drodze hipotez tak, aby nie były sprzeczne z bożym Pismem, musiałyby zostać całkowicie wyeliminowane z Kościoła bożego”.

Dziełko Ingolego miało także pełnić funkcję propagandową, ukazując reszcie Europy, że cenzura rzymska nie działa bez określonych zasad i w sposób arbitralny, lecz po dojrzałym namyśle i starannym rozważeniu racji. Autor miał też nadzieję, że „za pomocą powtarzania owa prześladowana prawda lepiej się ujawni i będzie mogła wejść w umysły ludzkie, tak aby fałszywe dogmaty Kopernika, które dzięki staraniom amatorów nowinek od niewielu lat zaczynają zajmować dusze śmiertelników, stopniowo popadły w zapomnienie i powróciły w mroki swej osobliwej niepewności”.ix Tak wielki zamysł tłumaczył nawet zuchwałość, na jaką porwał się Ingoli, polemizując ze sławnym Keplerem, do czego zresztą sam się z całą skromnością przyznaje.

Utrwalanie poglądu o nieruchomości Ziemi i odparcie kopernikanizmu, najwyraźniej zgodne z polityką Kościoła, nie było skutkiem administracyjnej pomyłki czy nierozważną decyzją. Nie chodziło też o żadne filozoficzne czy metodologiczne subtelności: zgodnie z Pismem Świętym Ziemia jest nieruchoma i tej prawdy postanowiono bronić wbrew wszelkim możliwym, lepszym czy gorszym, argumentom naukowym. Jak zobaczymy w dalszym ciągu, stanowisko to nie było także ograniczone czasowo do jakiegoś jednego pontyfikatu czy jednego składu Kongregacji Świętego Oficjum i Kongregacji Indeksu.

Francesco Ingoli, oprócz napisania odpowiedzi na tekst Keplera, zajął się bliżej jego nowym dziełem, Epitome astronomiae copernicane, o którym obaj wspominali w polemice. „Książka jest bardzo ciekawa i piękna” – stwierdzał teatyn w cenzurze przedstawionej Kongregacji Indeksu. Zawiera jednakowoż dwa mylne poglądy: kopernikanizm i twierdzenie, że Słońce jest ożywione, co jest błędem popełnionym już kiedyś przez Orygenesa. W rezultacie na posiedzeniu Kongregacji 28 lutego 1619 roku, odbytym w pałacu kardynała Bellarmina w obecności kardynała Barberiniego (przyszłego papieża) i pięciu innych kardynałów, postanowiono objąć Epitome astronomiae copernicanae całkowitym zakazem, bez żadnej możliwości poprawek.x

Kepler nie wiedział, z kim polemizuje ani że przyspiesza w ten sposób objęcie zakazem własnej książki. W pierwszej połowie roku 1619 dobiegał końca druk innego jego wielkiego dzieła, Harmonices mundi libri V („Harmonia świata w pięciu księgach”). Według cesarskiego matematyka układ planetarny Kopernika należało z jednej strony objaśniać za pomocą fizyki ruchu, i temu służyły odkryte przez niego wcześniej prawa, dziś zwane pierwszym i drugim prawem Keplera. Z drugiej strony należało także wyjaśnić, czym kierował się Stwórca, konstruując taki a nie inny układ planetarny: czemu orbity były tej właśnie wielkości, dlaczego np. orbita Marsa ma znaczne spłaszczenie, a orbita Wenus bardzo niewielkie itp. Wyjaśnień tego drugiego rodzaju szukał Kepler w geometrii i pitagorejskiej idei harmonii dźwięków. Orbity planet miały być w zawiły sposób zharmonizowane ze sobą i cesarski matematyk wierzył, że odkrył tę harmonię. W tej pitagorejsko-platońskiej linii poszukiwań naukowych przyszłość nie przyznała Keplerowi racji, ale przy okazji tych badań udało mu się odkryć jeszcze jedno prawo dotyczące planet: sześcian wielkości orbity jest proporcjonalny do kwadratu okresu obiegu. To prawo, w Harmonii świata ukryte pośród wielu rozważań, dziś nazywane trzecim prawem Keplera, uczony odkrył w tym samym miesiącu, w którym napisał swoją odpowiedź Ingolemu. Stanowi ono także stanowi mocny argument na rzecz kopernikańskiego wszechświata, tym bardziej że dotyczy wszelkich ciał krążących wokół wspólnego centrum i słuszne jest np. dla satelitów Jowisza – „gwiazd medycejskich” odkrytych i badanych przez Galileusza.

Harmonia świata była ulubionym tematem Keplera i zależało mu na tym, aby poświęcona jej książka mogła być sprzedawana także w Italii, gdzie już wcześniej trudno było kupić jego publikacje. Teraz, kiedy wprowadzono zakaz głoszenia kopernikanizmu, Kepler (nieświadomy jeszcze postanowień w sprawie Epitome) postanowił napisać swego rodzaju zapowiedź wydawniczą Harmonii świata, skierowaną do księgarzy w Italii. „Napisałem tę pracę jako Niemiec i wedle obyczaju i wolności niemieckiej. Im większa jest owa wolność, tym większą rodzi wiarę w szczerość tych, którzy uprawiają nauki. Jestem chrześcijaninem i synem Kościoła i uznaję naukę katolicką nie tylko samym sercem, ale także i głową, w takim stopniu, w jakim w mym obecnym wieku mogłem ją pojąć; składam tego dowody w niejednym miejscu książki. Tak więc to, co się w niej znajduje, nie niesie z sobą żadnego niebezpieczeństwa, może wytrzymać przyjętą w waszym kraju cenzurę i nie trzeba lękać się tego, co zawiera. Jedynie w nauce o ruchu Ziemi pojawia się trudność, gdyż z powodu nierozwagi tych, którzy nauki astronomiczne wykładali nie w swoim miejscu i niewłaściwą metodą, czytanie Kopernika, od lat niespełna osiemdziesięciu dozwolone (odkąd dzieło zadedykowane było papieżowi Pawłowi III), zostało zakazane aż do czasu wprowadzenia poprawek”.

Kepler, który jak sam pisze, od dwudziestu sześciu lat jest zwolennikiem Kopernika, wierzy, że książka o harmonii musi przekonać także i tych, którzy dotąd wątpili w prawdziwość heliocentryzmu. Proponuje, by księgarze rozpowszechniali jego dzieło jedynie wśród uczonych: „Wy, księgarze, postąpicie zgodnie z prawem i porządkiem, jeśli egzemplarzy [książki] ze względu na wyrok nie wystawicie publicznie na sprzedaż. Wiedzcie bowiem, iż jesteście dla filozofii i dla dobrych autorów jak notariusze, którzy dostarczają sędziom pisma obrończe. Sprzedawajcie więc książkę tylko najwybitniejszym teologom, najświatlejszym filozofom, najdoświadczeńszym matematykom, najgłębszym metafizykom, do których ja jako adwokat Kopernika nie mogę dotrzeć. Niech oni się zastanowią, czy mają do czynienia jedynie z wykwitem wybujałej fantazji, czy też raczej z czymś, co wywodzi się z samej natury i może być potwierdzone ewidentnymi dowodami. Niech się zastanowią, czy ta potężna chwała dzieł bożych ukazana powinna być wszystkim, czy też raczej zamknięta, a jej sława prześladowana cenzurą. Cokolwiek się zdarzy, czy Kopernik został, czy też dopiero zostanie przez nich poprawiony, niech zobaczą, czy astronomia Kopernika zarysowana w moich komentarzach o ruchach Marsa, rozwinięta w drugiej części Epitome astronomiae, która się właśnie drukuje, czy także owa harmoniczna konstrukcja ruchów niebieskich, przedstawiona w tej książce, może w ogóle istnieć, jeśli wyeliminuje się ruch Ziemi i zastąpi go ruchem Słońca. I za którą z dwóch hipotez należy iść: Kopernika czy Brahego (…) (gdyż starożytna [hipoteza] Ptolemeusza z pewnością jest fałszywa). Cokolwiek zostanie ustalone po wszystkich potrzebnych z natury rzeczy dowodach, z całą pewnością uznane zostanie za obowiązujące i święte przez wszystkich katolickich matematyków”.xi

Ukazujące się właśnie dzieła Keplera rzeczywiście były jednym wielkim argumentem za kopernikanizmem. W dalszym ciągu cytowanego tekstu do księgarzy, wśród szczegółów piątej księgi Harmonii świata, znajduje się jako punkt dziewiąty dokładne sformułowanie III prawa Keplera. Oczywiście współcześni nie od razu się zorientowali, z jakim bogactwem mają do czynienia. Nie rozumiał tego nawet Galileusz, a więc – zdawałoby się – sojusznik w kopernikańskiej sprawie. Jednak odkrycia zostały już dokonane, ich dalsze zrozumienie było wyłącznie kwestią czasu.

O ile jednak Kepler mógł być spokojny swych racji w długiej perspektywie, o tyle wiadomość, że zakazano Epitome, przyjął ze wzburzeniem. Dowiedział się o tym latem 1619 roku, gdy jeden z jego korespondentów, medyk cesarski Johannes Remus Quietanus, doniósł, że z powodu zakazu Galileusz nie może zdobyć egzemplarza Epitome. Wiadomość wyglądała groźnie, Kepler zaczął się obawiać o losy swoich książek zarówno już wydrukowanych, jak i tych, które zamierzał wydać. Jeśli cenzura obejmie Austrię, nie znajdzie drukarza, a wydrukowane egzemplarze przepadną. Przez dwadzieścia sześć lat mógł spokojnie rozwijać badania, opierając się na teorii Kopernika, a teraz być może przyjdzie mu porzucić astronomię albo opuścić cesarstwo. Na szczęście dekrety rzymskie miały niewielką siłę sprawczą poza Italią i Kepler mógł dokończyć swoje prace. Nie jest jasne, czy zakazana została całość Epitome, ponieważ dalsze księgi wyszły na świat już po ogłoszeniu dekretu Kongregacji Indeksu. Chyba później stracono zapał do przyglądaniu się dorobkowi Keplera, żadna inna jego książka nie trafiła na indeks.

i Tommaso Campanella,Apologia pro Galileo,s. 9.

ii R. Hooykaas, Religia i powstanie nowożytnej nauki, przeł. S. Ławicki, Instytut Wydawniczy PAX, Warszawa 1975, s. 143 i n.

iii Johannes Kepler, Astronomia nova, Gesammelte Werke, t. III, s. 30, 33.

iv Francesco Ingoli, De situ et quiete Terrae contra Copernici systema disputatio, OG V, s. 411.

v Johannes Kepler, Epitome astronomiae copernicanae, Lib. I, Pars 5, w: Joannis Kepleri astronomi Opera omnia, t. 6, Francofurti et Erlangae 1866, s. 176.

vi Francesco Ingoli, Replicationes ad Kepleri impugnationes, w: M. Bucciantini, Contro Galileo: alle origini dell’affaire, Leo S. Olschki, Firenze 1995, s. 201.

vii Johannes Kepler, Responsio ad Ingoli disputationem de systemate, Gesammelte Werke, t. 20.1, s. 176, 179.

viii Por. Cz. Miłosz, Metafizyczna pauza, Wydawnictwo Znak, Kraków 1989, s. 61.

ix Francesco Ingoli, Replicationes ad Kepleri impugnationes, w: M. Bucciantini, Contro Galileo, s. 178.

x P.N. Mayaud, La condamnation des livres coperniciens, s. 59, 65-66.

xi Johannes Kepler, Admonito ad bibliopolas exteros, praesertim italos de Opere Harmonico, Opera omnia, t. V, Francofurti et Erlangae 1864, s. 8-9.

Najprawdopodobniej Hooke nie zrozumiałby tej metody, gdyby Newton mu ją przedstawił. W każdym razie daleko mu było do samodzielnego obliczenia kształtu toru w którymkolwiek przypadku.

Najprawdopodobniej Hooke nie zrozumiałby tej metody, gdyby Newton mu ją przedstawił. W każdym razie daleko mu było do samodzielnego obliczenia kształtu toru w którymkolwiek przypadku.