Hamilton był cudownym dzieckiem, miał nadzwyczajną pamięć i szybko uczył się przedmiotów formalnych. Z początku oznaczało to martwe bądź egzotyczne języki: łacina, greka i hebrajski w wieku pięciu lat, do czego w dojrzałym wieku lat dziewięciu doszły tak niezbędne w Irlandii perski, arabski, sanskryt, chaldejski, syryjski, hindi, bengalski, malajski itd. Tak przynajmniej twierdził jego ojciec, który go zresztą nie wychowywał, od trzeciego roku życia chłopiec mieszkał bowiem i uczył się u jego brata pastora (rodzice zmarli, zanim William dorósł). Dzięki zetknięciu z arytmetycznymi popisami sawanta Zeraha Colburna, reklamowanego jako „American calculating boy”, lubiący się popisywać Hamilton zajął się arytmetyką, a później szerzej matematyką i fizyką matematyczną. Przeczytał Principia Newtona, a mając siedemnaście lat spostrzegł błąd w pewnym miejscu monumentalnego Traité de mécanique céleste Laplace’a. Ktoś powiedział o tym Johnowi Brinkleyowi, Królewskiemu Astronomowi Irlandii, który zwrócił uwagę na młodego człowieka. W wieku dwudziestu dwóch lat Hamilton objął to stanowisko po ustępującym Brinkleyu. Miał już do tego czasu liczący się dorobek naukowy w dziedzinie optyki i mechaniki. W obu tych dziedzinach prace Hamiltona były wybitne i zapoczątkowane przez niego metody rozwijane są do dziś. Jednak głównym tematem pracy Hamiltona, jego wieloletnią obsesją, stały się kwaterniony.

Początkowo Hamiltonowi chodziło o uogólnienie liczb zespolonych na trzy wymiary.

Liczby zespolone można uważać za uogólnienie liczb rzeczywistych, dzięki któremu równania wielomianowe mają zawsze pierwiastki. Wiemy, że w dziedzinie rzeczywistej nawet tak proste równanie, jak nie ma rozwiązania, gdy

. Można temu zaradzić, wprowadzając liczby urojone, będące pierwiastkami kwadratowymi z liczb ujemnych:

, gdzie jednostka urojona

musi spełniać warunek

. Liczby urojone możemy dodawać do liczb rzeczywistych, powstają wówczas liczby zespolone postaci

, gdzie

są rzeczywiste. Okazało się, że liczby zespolone są pojęciem wybranym bardzo udatnie: nie tylko równania algebraiczne w dziedzinie zespolonej mają zawsze rozwiązania, ale teoria funkcji zmiennej zespolonej jest piękną dziedziną matematyki z wieloma zastosowaniami. Można takimi metodami badać własności liczb pierwszych (twierdzenie o rozmieszczeniu liczb pierwszych, hipoteza Riemanna), liczby zespolone pojawiają się też u podstaw fizyki, w równaniu Schrödingera – mechanika kwantowa wymaga liczb zespolonych, dzięki nim opisuje się zjawisko interferencji kwantowej.

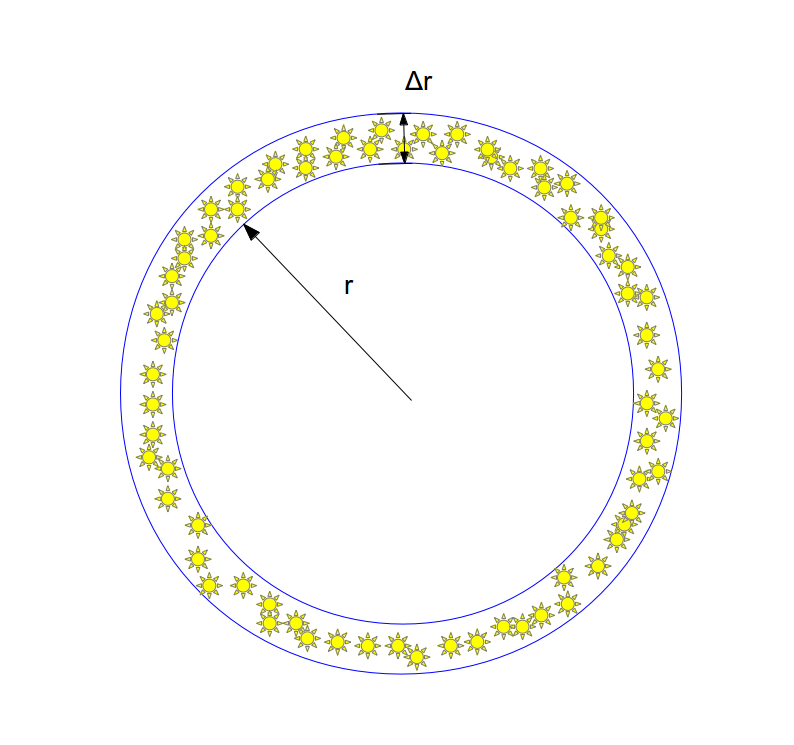

Hamilton poszukiwał uogólnienia liczb zespolonych na trójki liczb. Chciał, aby trójki takie można było dodawać i mnożyć przez siebie. Mnożenie miało być rozdzielne względem dodawania, tak żeby można było stosować zasady zwykłej algebry. Żądał także, aby przy mnożeniu mnożyły się moduły liczb: . W przypadku liczby zespolonej

moduł równa się

, w przypadku trypletów mielibyśmy pod pierwiastkiem sumę trzech kwadratów. Gotów był natomiast poświęcić przemienność iloczynu, co było krokiem oryginalnym i raczej przedtem niepraktykowanym. Przez dłuższy czas co rano, gdy Hamilton schodził na śniadanie, jego syn pytał: „Tato, czy potrafisz już mnożyć tryplety?”, na co uczony, potrząsając smutno głową, odpowiadał: „Niestety, nie, umiem je tylko dodawać i odejmować”.

Rozwiązanie, które pojawiło się w głowie Hamiltona w październikowy ranek, polegało na uogólnieniu idącym jeszcze o krok dalej: zamiast trójek, należy rozpatrywać czwórki liczb rzeczywistych. Hamilton przechodził właśnie z żoną w pobliżu mostu Broome Bridge w Dublinie i na pamiątkę tej chwili wyrył na jego kamieniach prawa rachunku kwaternionów. Potrzeba aż trzech dodatkowych wymiarów: .

Plakietka zastępująca wytarty wpis Hamiltona

Kwaterniony tworzą algebrę z dzieleniem, strukturę zachowującą wszystkie oprócz przemienności reguły działań na liczbach zespolonych. Wkrótce potem przyjaciel Hamiltona John T. Graves i niezależnie Arthur Cayley odkryli oktoniony, mające osiem składowych. Jednak w ich przypadku należało zrezygnować także z łączności mnożenia: . Nauczyciel A. Einsteina na Politechnice w Zurychu, a później także jego przyjaciel, Adolf Hurwitz udowodnił, że jeśli chcemy, by zachodziło mnożenie modułów, to liczby rzeczywiste

, zespolone

, kwaterniony

oraz właśnie oktoniony wyczerpują wszystkie możliwości. Trudności Hamiltona z mnożeniem trypletów były nie do pokonania, a znalezione wyjście z sytuacji – praktycznie jedyne.

Do czego można było zastosować tak dziwne czterowymiarowe obiekty w XIX wieku? Czasoprzestrzeń była wciąż daleką przyszłością, choć Hamilton spekulował, iż kwaternion składa się z części skalarnej i wektorowej – oba terminy zostały zastosowane właśnie przez niego po raz pierwszy. Dziwne reguły formalne algebry kwaternionów przyjmowane były z pewnymi oporami: bo czy matematyk może zadekretować, co zechce, byle tylko nie popaść w sprzeczność? Dziś takie stanowisko znajduje znacznie więcej zrozumienia niż w połowie XIX wieku, ale i dzisiejszy czytelnik może się zastanawiać, czy aby na pewno obiekty o takich własnościach istnieją. Kwaterniony pozwoliły na krótszy zapis niektórych wyrażeń zawierających wektory. Wektor można przedstawić w postaci

jest on więc szczególnym rodzajem kwaternionu z zerową częścią skalarną (zwanym czasem czystym kwaternionem):

Kwadrat takiego kwaternionu jest równy

gdzie skorzystaliśmy z tabelki mnożenia Hamiltona. Iloczyn dwóch czystych kwaternionów nie jest więc kwaternionem czystym i ma na ogół niezerową część skalarną:

gdzie to iloczyn skalarny, a

– iloczyn wektorowy obu wektorów. Oba te pojęcia czekała znaczna kariera w analizie wektorowej, ale dopiero po uwolnieniu się z gorsetu kwaternionów. Oczywiście i przedtem wiele wyrażeń spotykanych w rozważaniach geometrycznych czy mechanicznych de facto sprowadzało się do tych iloczynów. Współczesnego czytelnika nieco odstręcza powtarzanie trzy razy wyrażeń, które są składowymi pewnego wektora w dziełach, np. Eulera czy Lagrange’a. Użycie iloczynu wektorowego upraszcza zapis, choć też ogranicza go do przypadku trójwymiarowego, bo tylko trójwymiarowe wektory pomnożone „wektorowo” dają w wyniku wektor trójwymiarowy. Uproszczenie zapisu jest zawsze pożądane, choć trudno je uznać za wiekopomne odkrycie (por. konwencję sumacyjną Einsteina).

Ambicje Hamiltona sięgały znacznie dalej i kwaterniony stały się jego ulubionym tematem, którym zajmował się przez następne dwadzieścia lat, aż do śmierci. Mimo że Hamilton pracował sam i w Dublinie był raczej osamotniony naukowo, jego odkrycie wzbudziło zainteresowanie i powstała szkoła zwolenników takiej metody formułowania problemów. Dość powiedzieć, że w jednym z wydań swego fundamentalnego traktatu o elektryczności i magnetyzmie, James Clerk Maxwell zastosował formalizm kwaternionów. Było to już po śmierci Hamiltona i w przyszłości formalizm ten wyszedł praktycznie z użycia. Druga połowa życia Hamiltona była mniej twórcza, uczony poszukiwał wciąż nowych zastosowań kwaternionów, napisał na ich temat potężne tomisko, niezbyt czytane, jak łatwo się domyślić, i do ostatnich dni pracował nad krótszym do nich wprowadzeniem. Trzeźwą ocenę kwaternionów sformułował lord Kelvin w 1892 r.:

Kwaterniony odkryte zostały przez Hamiltona już po jego naprawdę bardzo dobrych pracach i choć są pięknym pomysłem, stały się czystym złem dla wszystkich, którzy ich tknęli, włącznie z Jamesem Clerkiem Maxwellem.

Konserwatywny Kelvin miał dużo racji. Łączenie w jedną całość trójwymiarowych wektorów i skalarów jest niezbyt szczęśliwym pomysłem w fizyce. Hamilton nie potrafił oprzeć się urokowi swej koncepcji, lecz jej zastosowania nie stały się głównym nurtem matematyki ani fizyki. Choć co jakiś czas ktoś próbuje ich nowych zastosowań, jak np. kwaternionowa mechanika kwantowa. Wielką umiejętnością jest w nauce nie tylko dostrzeganie tematów, ale także ich porzucanie, kiedy nie rokują zbyt dobrze. Takim tematem przyciągającym niektórych jak ćmy do ognia było przez wieki Wielkie Twierdzenie Fermata, sporo karier matematycznych nadwyrężyły bądź zniszczyły nieudane próby jego udowodnienia.

Mnożenie kwaternionów jest nieprzemienne i w można je powiązać z obrotami w przestrzeni trójwymiarowej, co zauważył zresztą sam Hamilton. Zastosowanie to odżyło dziś dzięki grafice komputerowej. Kwaterniony są tu jednak wyłącznie wygodnym narzędziem, jednym wśród wielu. Okazuje się, że kwaternion o jednostkowym module

gdzie jest wektorem jednostkowym, opisuje obrót o kąt

wokół osi

. Obrót taki zdefiniowany jest w języku kwaternionów jako przekształcenie wektora

w wektor

:

Widać, że składaniu obrotów odpowiada mnożenie kwaternionów, łatwo jest w takim sformułowaniu podzielić ruch na mniejsze kroki, co przydaje się w przedstawianiu ruchu obiektów 3D. Kwaterniony o jednostkowym module z operacją mnożenia zwaną tworzą grupę, nazywaną Sp(1). Ma ona bliski związek z grupą obrotów w przestrzeni trójwymiarowej, ale nie jest z nią tożsama, gdyż dwa kwaterniony dają ten sam obrót. Inaczej mówiąc, kwaternion odpowiadający obrotowi o

, to

. Znak minus nie wpływa na obrót wektora, więc mogłoby się wydawać, że jest to tylko pewna matematyczna ciekawostka, gdyż

. Okazuje się jednak, o czym nie wiedziano w wieku XIX, że do opisu świata fizycznego potrzebne są obiekty zmieniające znak po obrocie o

– są to spinory. Za ich pomocą opisuje się np. elektrony, ogólnie wszelkie cząstki o spinie

.

Jak zrozumieć postać kwaternionu opisującego obrót? Każdy obrót o kąt

jest złożeniem dwóch symetrii zwierciadlanych wzgledem płaszczyzn przecinających się pod kątem

. Z kolei operacja

jest odbiciem zwierciadlanym w płaszczyźnie prostopadłej do wektora jednostkowego . Dla obrotu o kąt

wokół wektora jednostkowego

możemy znaleźć dwa wektory jednostkowe

, które spełniają warunki

a więc zgodnie z zasadami mnożenia kwaternionów kwaternion odpowiada złożeniu symetrii zwierciadlanych, czyli obrotowi. Szczegóły znaleźć można w książce M. Zakrzewskiego, Markowe wykłady z matematyki: Geometria, albo A.F. Beardona, Algebra and geometry.

Wariant tego urządzenia zamontowany był w domu Franklina w Filadelfii: między piorunochronem a uziemieniem biegnie drut przerwany dwoma dzwonkami. Wahadełko umieszczone pomiędzy obu dzwonkami poruszało się, gdy pojawiał się w układzie ładunek. Żona badacza, Deborah, w słusznym odruchu twierdziła, że boi się tego dzwonienia podczas burzy czy wtedy, gdy się ma na burzę. Małżonek, przebywający w Londynie, zezwolił jej wówczas na zdemontowanie dzwonków.

Wariant tego urządzenia zamontowany był w domu Franklina w Filadelfii: między piorunochronem a uziemieniem biegnie drut przerwany dwoma dzwonkami. Wahadełko umieszczone pomiędzy obu dzwonkami poruszało się, gdy pojawiał się w układzie ładunek. Żona badacza, Deborah, w słusznym odruchu twierdziła, że boi się tego dzwonienia podczas burzy czy wtedy, gdy się ma na burzę. Małżonek, przebywający w Londynie, zezwolił jej wówczas na zdemontowanie dzwonków.